La IA debe generar no poner en peligro la autonomía de un individuo, no defender ni profanar los derechos humanos y promover, en lugar de poner en peligro, el bienestar social.

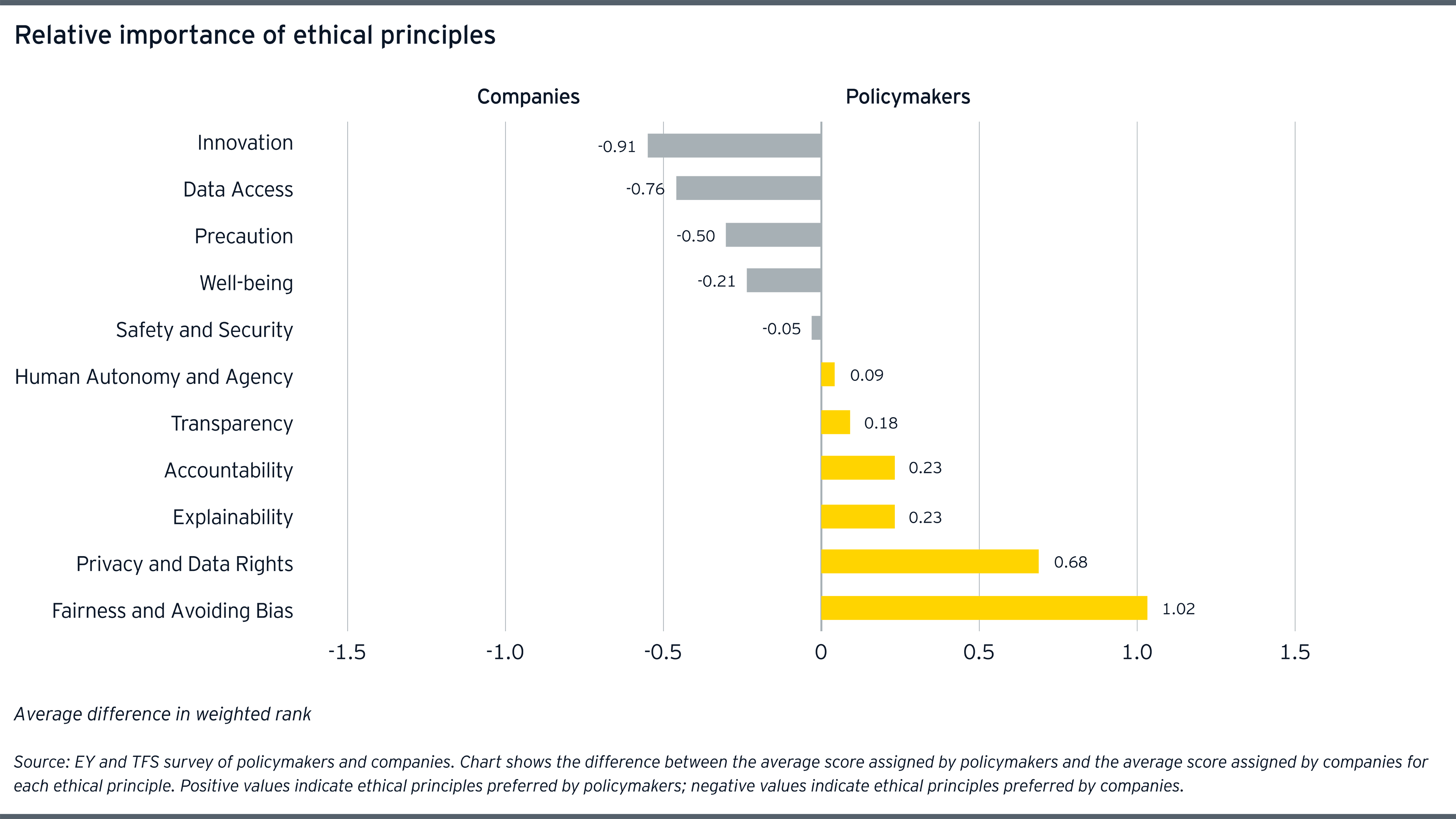

Los importantes desajustes en torno a la equidad y la evitación de los prejuicios generan riesgos de mercado considerables, ya que las empresas pueden estar desplegando productos y servicios mal alineados con los valores sociales emergentes y la orientación normativa. Para ilustrar esto, la reciente agitación social en los EE.UU. en medio de la pandemia demuestra la intensa ira pública dirigida contra la discriminación. Las marcas que despliegan algoritmos sesgados se arriesgan a soportar esa ira.

La segunda diferencia más importante se produjo en torno al principio de la innovación, al que la industria dio mayor prioridad en los 12 casos de uso en comparación con los encargados de la formulación de políticas. Aunque tal vez no sea sorprendente, la innovación con la IA está inexorablemente vinculada a los riesgos creados y éstos varían según el caso de uso. Si se analizan los datos personales para crear un nuevo producto, se suele renunciar a la privacidad (por ejemplo, los "datos de capacitación") antes de que se libere el algoritmo. Si una IA modifica de forma inapropiada el comportamiento de alguien, es posible que no pueda recuperar la autonomía perdida.

El mayor énfasis relativo de las empresas en el principio de la innovación indica que tal vez no estén evaluando plenamente los riesgos éticos cuando emprenden proyectos de transformación o durante la investigación y el desarrollo de productos y servicios de la IA. Esta conclusión está respaldada por la reciente EY global board risk survey que muestra que sólo el 39% de las empresas creen que sus prácticas de riesgo empresarial gestionan adecuadamente los riesgos no tradicionales o emergentes, como los creados por la construcción y el despliegue de nuevas aplicaciones de IA. Es necesario mejorar las técnicas de gestión de riesgos para equilibrar esos riesgos con los importantes beneficios que ofrece la IA.

La pandemia de COVID-19 pone de relieve la tercera y cuarta área de divergencia en nuestro estudio; inevitablemente, existe un equilibrio entre el acceso a los datos por un lado, y la privacidad y los derechos de los datos por el otro. Los datos son un aporte fundamental para la producción de innovadores y nuevos algoritmos de IA. El entrenamiento de una IA para escanear el tejido pulmonar humano requiere que las personas presenten registros médicos. La identificación de grupos para permitir el rastreo significa que las personas deben compartir algunos datos privados de localización e información de contacto.

Artículo Relacionado

Los encargados de la formulación de políticas encuestados sitúan la privacidad y los derechos de los datos como una consideración ética primordial en el desarrollo de la IA, mientras que muchos profesionales de la industria, en cambio, hacen hincapié en el acceso a los datos. El uso indebido de los datos personales ha sido uno de los principales impulsores de la reciente reacción contra las empresas de tecnología, y la pandemia puede estar agravando esas preocupaciones a medida que proliferan las aplicaciones invasivas. En los casos en que una encuesta reciente muestra que el 53% de los consumidores están dispuestos a compartir sus datos personales para ayudar a vigilar y rastrear COVID-19, es posible que esas preferencias no se traduzcan de manera más amplia o que continúen una vez que la crisis inmediata haya remitido.

La derogación de los principios de privacidad y justicia, ya sea intencional o por accidente, impone costos significativos a las personas. Los algoritmos discriminatorios pueden amenazar aún más a algunas de las poblaciones más vulnerables de la sociedad, incluidas las minorías étnicas y las mujeres — muchas de las cuales se ven afectadas de manera desproporcionada por la pandemia y las repercusiones económicas conexas. Los riesgos de privacidad son tal vez más graves para los niños, que carecen de la experiencia necesaria para protegerla por sí mismos, pero que ahora pasan mucho más tiempo online para continuar con el aprendizaje a distancia en medio del cierre generalizado de escuelas. El consenso de los encargados de la formulación de políticas en torno a los principios de privacidad y equidad sugiere que la resolución de las prioridades éticas conflictivas de las empresas es fundamental para calmar las preocupaciones del público.

Por lo tanto, la planificación de la transformación debe tener en cuenta los nuevos riesgos éticos. La confianza en las nuevas tecnologías variará en función de las condiciones culturales y políticas locales, así como de los regímenes reglamentarios y de gobernanza. Por ejemplo, el principio de "limitación del propósito" está consagrado en el Reglamento General de Protección de Datos de Europa. Esta norma restringe la forma en que los datos personales reunidos para un uso pueden ser reutilizados para otras aplicaciones en el futuro y puede alentar una mayor aceptación del intercambio de datos invasivos que en los lugares que carecen de tales restricciones. Si bien la respuesta a la pandemia es una necesidad urgente, el aumento de la eficiencia a expensas del debilitamiento de las libertades y los derechos humanos no creará una confianza pública duradera. El actual entorno de baja confianza se traduce en una adopción más débil, a su vez, socavando el vasto potencial de las aplicaciones de salud pública impulsadas por la IA.

Artículo Relacionado

La brecha en las expectativas

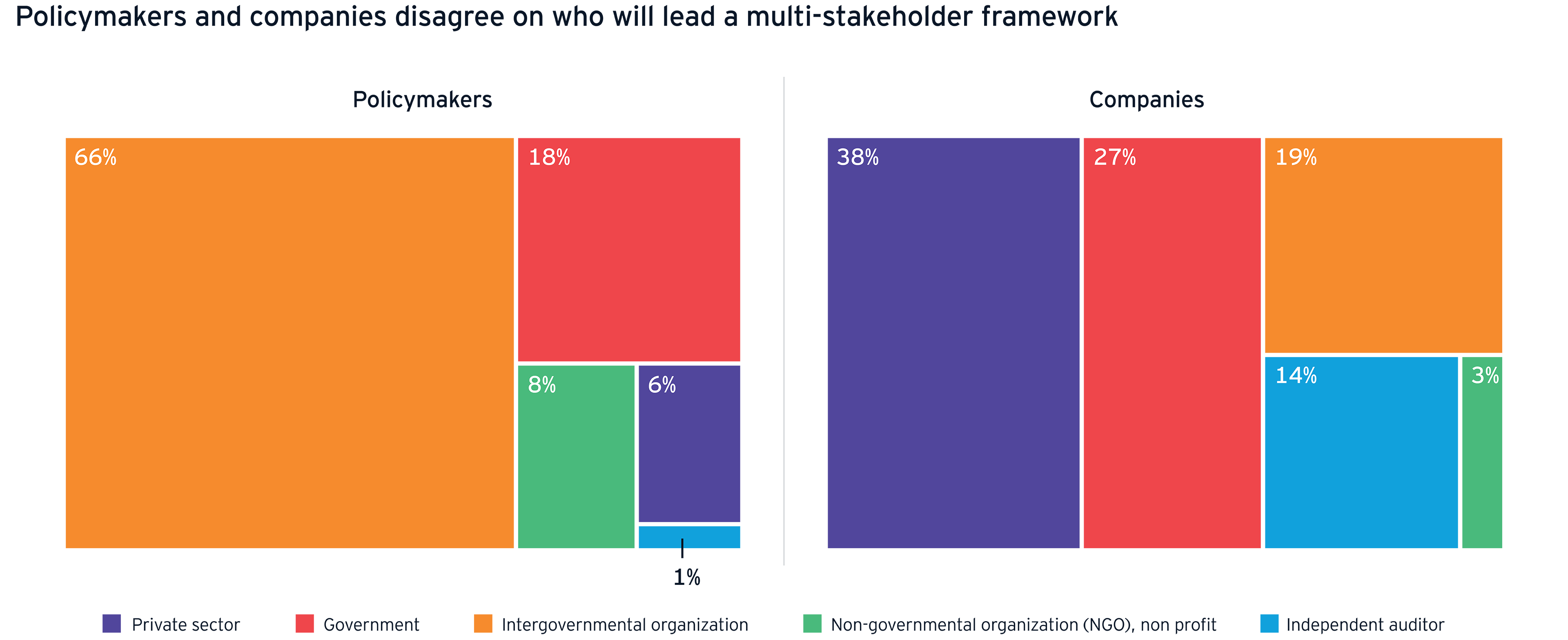

Además de los desajustes éticos, la encuesta revela una gran brecha de expectativas. La industria ha prometido la autorregulación durante algún tiempo, pero sigue sin haber progresos verificables en los principales desafíos que enfrenta el sector de la tecnología, como la desinformación y los abusos de la privacidad. El 38% de las empresas siguen creyendo que liderarán cualquier proceso de elaboración de normas. Sin embargo, el 84% de los encargados de la formulación de políticas esperan que los actores estatales dominen. Una divergencia tan grande en las expectativas es preocupante e indica que algunas empresas se sorprenderán de la dirección y el alcance de los próximos cambios legislativos. Los riesgos legales y de cumplimiento se producen cuando la industria no está bien alineada con los responsables de las políticas. Estos riesgos se agravan cuando los productos se lanzan al mercado para satisfacer requisitos de emergencia o cuando se aplican planes de transformación multianuales en cuestión de semanas.

Con la fase deliberativa de la regulación de la IA llegando a su fin, los responsables políticos están ahora claramente yendo más allá de los principios y hacia la práctica. La pandemia de COVID-19 no ha demorado este programa legislativo, sino que está dando un nuevo impulso a medida que se multiplican las aplicaciones de salud pública impulsadas por la IA. Esto significa que la ventana que permite a las empresas alinearse voluntariamente con el marco de gobernanza emergente se está cerrando rápidamente. Las empresas en condiciones normales corren el riesgo de sufrir una mayor carga de ajuste cuando llegue pronto una gobernanza más estricta.

Mitigar estos riesgos antes de que se materialicen requiere un liderazgo compromiso de crear confianzaLas aplicaciones de la IA implementadas deben reflejar los valores de la compañía. La IA debe fomentar no poner en peligro la autonomía de un individuo, defender y no desacreditar los derechos humanos y promover, en lugar de poner en peligro, el bienestar social.

Adoptar una IA ética

A medida que las empresas se den cuenta de los beneficios de la IA, al aportar más productos y servicios al mercado, una gobernanza más firme ayudará a la gestión de los riesgos. Una reglamentación apropiada puede mantener la IA segura y protegida sin violar la privacidad o las libertades fundamentales de los individuos. Unas normas mejores harán que las empresas sean plenamente responsables de los resultados de sus innovaciones en materia de IA. Y unas salvaguardias más firmes ayudarán a garantizar que la IA de confianza desplegada en el mundo real sea justa, transparente y explicable. Esto aumentará la confianza del público y, por tanto, la adopción por parte de los consumidores, desbloqueando nuevos productos y estrategias con mayor rapidez y dinamizando el uso de la IA en las agendas de transformación.

La crisis de COVID-19 pone la IA ética en el foco, convirtiéndola en una característica central de cualquier estrategia de transformación digital. El primer paso para realinearse con la ética emergente es fomentar un consenso interno en torno a los principios clave en todas las divisiones, incluyendo la tecnología, los datos, el riesgo, el cumplimiento, el aspecto legal, las ventas, los recursos humanos y la gestión. La participación de un conjunto más amplio de stakeholders, como los clientes que pueden ser discriminados por los productos y servicios de la IA, promueve la confianza en un clima social volátil. Por ejemplo, para reducir al mínimo el riesgo de sesgo algorítmico, las empresas deberían crear activamente conjuntos de datos de capacitación diversos e inclusivos que representen equitativamente a los grupos vulnerables. En el clima social actual, el despliegue descuidado de algoritmos potencialmente discriminatorios representa un riesgo de marca sustancial y creciente. Las empresas también podrían considerar la posibilidad de validar sus programas informáticos mediante auditorías externas de sus procesos de producción, entradas de datos y salidas algorítmicas.

La transparencia también ayuda a crear la confianza necesaria para impulsar la adopción. Las empresas deben convertir los principios éticos en directrices claras y publicadas para el suministro de productos y servicios de IA. Deberían formalizarse las líneas de responsabilidad. Se requieren políticas y procedimientos corporativos para facilitar los exámenes periódicos y las evaluaciones continuas de los riesgos, y para actualizar los sistemas y productos en consecuencia. La administración debe proporcionar a los empleados los recursos y la capacitación necesarios para reforzar estos fundamentos cruciales y seguir aprendiendo a medida que evoluciona el entorno. La consulta con los encargados de la formulación de políticas para comprender cómo los principios éticos emergentes influirán en la evolución de la reglamentación de la IA en su sector ayuda a garantizar una alineación continua.

Una confianza débil de los consumidores corre el riesgo de frenar la adopción de tecnologías de transformación, incluso de salvamento. A medida que la crisis sanitaria se expande en una crisis social y económica, la IA ética se está convirtiendo en un prerrequisito para construir un mejor mundo de negocios.

Resumen

Está surgiendo un poderoso consenso entre los encargados de formular políticas en relación con los principios para la aplicación ética de la IA. Los gobiernos están dispuestos a convertir la ética en normas y reglamentos de obligado cumplimiento, pero la industria y los encargados de la formulación de políticas no están de acuerdo con los enfoques de la gobernanza y divergen en cuanto a los principios fundamentales. Una alineación deficiente disminuye la confianza del público en la IA, lo que frena la adopción de aplicaciones críticas. Están surgiendo nuevos riesgos a medida que los planes de transformación digital acelerada se enfrentan a graves condiciones de salud pública, sociales y económicas. Cerrar la brecha de confianza en la IA es una prioridad fundamental.