- 倫理的、法的、プライバシーリスク:データプライバシーや公平性、バイアス、規制などに関するリスクを考慮し、ユースケースのAIモデルタイプ、企業の知的財産、要配慮個人情報の利用を評価する。

- データ、アルゴリズム、開発リスク:入力データ、技術スタック、使用されるモデル、モデル出力、開発方法に基づいてリスクを評価することで技術的な複雑さを説明する。

- ビジネスリスク:収益、顧客体験、規制の準拠、企業のレピュテーションに対する潜在的な危害を評価することで潜在的な悪影響を説明する。

ユースケースのリスクティア分類の結果により、以下の2つのことが決定されます。

- 本番環境でのAIシステムに実装される、特定の責任あるAIのコントロールとモデルモニタリング。モニタリングには、パフォーマンスの正確性、バイアス、エンドユーザーの誤用、敵対的異常などの追跡が含まれ、責任あるAIのコントロールには、データプライバシー、データ保持、セキュリティ、ITおよび適用される法的ポリシーまたはそのどちらか一方に対するユースケースのコンプライアンス準拠を追跡するようなガバナンス活動が含まれる。

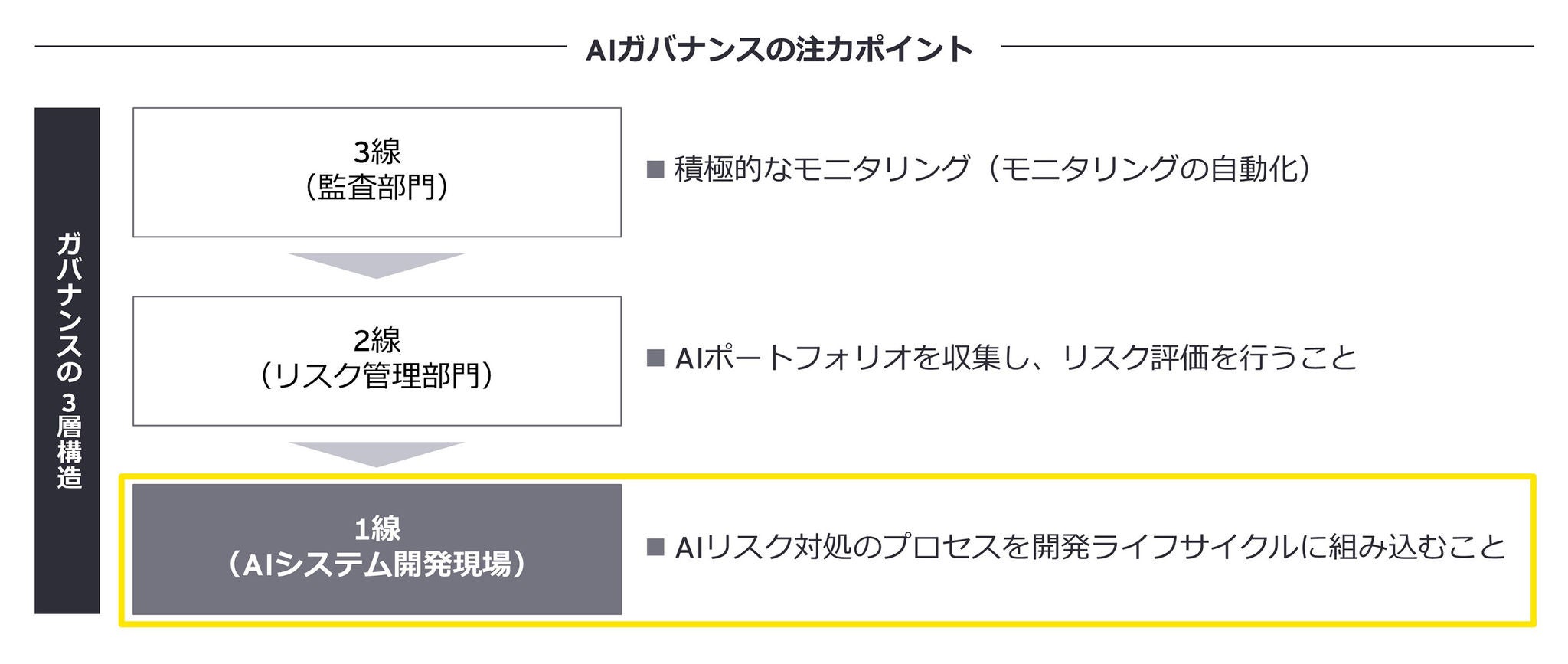

- AIシステムの本番環境でのライフサイクル全体にわたって、AIガバナンス構造の3つの防衛線内にあるさまざまなグループからのAIシステムのレビューと評価を継続的に実施する。

柱3 - ソリューション開発ライフサイクルに組み込まれた責任あるAI

AIシステム開発ライフサイクルの各フェーズには、適切なモニタリングが必要となる潜在的なリスクがあります。すべてのプロジェクトで責任あるAIに配慮して開発することで、企業は本質的にリスクを回避したAIシステムを構築することができます。AIライフサイクルには、以下に示すさまざまなリスクカテゴリが存在します。

- ユースケースの開始フェーズ:設計リスク

- データの取得と準備:データリスク

- AIモデルのトレーニング、実験、検証:アルゴリズムリスク

- AIの展開と監視:パフォーマンスリスク

EYの責任あるAIのフレームワークでは、開発チームが各フェーズで発生するおそれのある特定のリスクをチェックし、分析することを支援します。特定のビジネスから発生する機微なリスクに対処するために、リスクの軽減活動を標準のソリューション開発ライフサイクルの一部として組み込むべきです。

例えば、デジタル化の不足やデータドメインの整理不足、部門間でのデータ所有権の散在などの理由で、AIのモデルトレーニングに必要なデータセットが容易に入手できない場合、そのトレーニングを進める前にデータセットの不均衡を分析することが、データやアルゴリズムのリスクを軽減するためには重要です。また、AIシステムの出力からバイアスや不正確さが生じる可能性を明らかにすることができるために、モデルのトレーニングに使用されたデータセットの種類についての透明性を確保することも重要です。AIシステムを利活用するビジネス領域によっては、統計的な観点からバイアスのある出力が発生してしまい、ビジネスにとって不正確なインプットを提供するなどのパフォーマンスリスクを引き起こす可能性があります。人事領域で一般的に使用されるような人口統計データ利用するAIシステムでは、社会的バイアスも発生する可能性があります。

柱4 - 積極的なモニタリングとコントロール

AIプログラムが拡大するにつれ、リスク軽減のためのモニターの検討と機能の効率化が必要になるでしょう。具体的なモニター機能を特定のユースケースのリスクに基づいて設定しなければなりません。安全なAIの実践を確実に行うためには、生成AIの登場によって高まった多くの潜在的なリスクに対処する必要があり、さまざまな領域でのモニタリングが必要です。以下は、主要なリスクカテゴリの一部です。

ハルシネーション

AIシステムがトレーニングデータや提供された入力に基づかない出力や結論を生成し、不正確で、でたらめな、または有害な応答を引き起こすこと。

コントロールの例

- モデルが根拠のない、または想像上のコンテンツを生成しないようにする

- 指定されたユースケースの範囲外のコンテンツをスクリーニングするためのパラメータを設定する

- ハルシネーションであることを判別できるような、異常を特定するためのメトリクスをさまざまな領域に応じて作成する

データ漏えい

AIモデルのトレーニングデータ、予測出力、またはメタデータを通じて、機微・機密データが意図せず公開・共有されること。これにより、プライバシー侵害やセキュリティ脅威が生じる可能性がある。

コントロールの例

- データ出力を厳重に監視し、ユーザーの機密性を保護する

- 機微情報の偶発的な開示を防ぎ、ユーザーのプライバシーとセキュリティを強化する

プロンプトインジェクション

AIモデルに与えられた指示やクエリを意図的に操作し、有害であったり、誤解を招いたりするような、あるいは不適切な応答を生成し、事前に設定されたセキュリティガードをすり抜けること。

コントロールの例

- モデルが自身の安全機構を回避するように操作されることを防御する

- モデルの安全策の堅牢性を調整し、モデルの悪用に対して影響されにくくする

- 指定されたユースケースのパラメータに基づいてモデルの機能を確保する

有害性

特定の入力に対する応答として、またはAIシステムによって独自に生成された、有害または攻撃的なコンテンツ。これは、個人やグループに対して害を与えたり、不快感を引き起こしたりする可能性がある。

コントロールの例

- 有害、攻撃的、または不適切なコンテンツの生成を「有害性」として積極的に特定し、軽減する

- コンテンツモデレーションプロトコルを体系的に強化する

- ユーザーのウェルビーイングを損なう可能性のあるコンテンツや、プラットフォームのガイドラインに違反するコンテンツを事前に無効化する

上記のAIモデルリスクのカテゴリに対するコントロールを自動化することは、事前段階でも、あるいは遡及的にも行うことができます。事前のコントロールには、有害な言語、データ漏えい、プロンプトインジェクションに対するスキャニングやガードレールを設定することや、ユースケースの目的からのコンテキストの変動に対する閾値を設定することなどの対策が含まれています。事前のコントロールで対処できるリスクは、入力および出力の両面から監視することができます。一方、遡及的なモニタリングでは、過去のデータやモデルのパフォーマンスを明らかにし、改善の余地、再発する問題、新たなリスクを特定することが可能です。そのため、責任あるAIコントロールの自動化は、継続的で効率的な監視体制を強化し、また、AIプラットフォームアーキテクチャのレベルや、ローンチ後のデータレビューで実行が可能です。

責任あるAIプログラムの開発では、技術的なコントロールと機能的なプロセスが重なり合う点を見つけることが成功の秘訣です。AIシステムを、責任ある、スケーラブルな、かつ、望み通りのものとするために、データサイエンスチームと技術チームは、AIガバナンス部門や各ビジネス部門が設定したガイドラインや規制に従わなければなりません。一方、ガバナンス機関は、技術チームと協力して、出現するリスクや変化する外部環境に基づいてこれらのルールを継続的に改善させる必要があります。このような協力体制を通じて、AIは倫理的かつ有益な方法で利用され、ビジネス戦略、顧客の信頼、ブランドの評判にポジティブに貢献することができます。